Google en problemas: viralizan respuestas bizarras generadas por IA Overviews

La función, denominada "Descripciones generales de IA", se ha vuelto tendencia tras lanzarse en Estados Unidos.

Los resultados de búsqueda generados por la IA de Google ya están siendo tachados de "desastre" en el que "ya no se puede confiar", y los críticos citan respuestas extrañas que incluyen recomendar agregar pegamento a la salsa de pizza y promocionar los beneficios del tabaco para la salud de los niños.

En una característica controvertida que, según los críticos, plantea graves amenazas a los medios de comunicación tradicionales, el chatbot de Google genera automáticamente resúmenes para consultas complejas de los usuarios y, al mismo tiempo, degrada de manera efectiva los enlaces a otros sitios web.

La función, denominada "Descripciones generales de IA", se lanzó a todos los usuarios de Estados Unidos a partir de la semana pasada y se espera que llegue a más de mil millones de usuarios para fin de año, a pesar de los continuos errores que han afectado la credibilidad del chatbot.

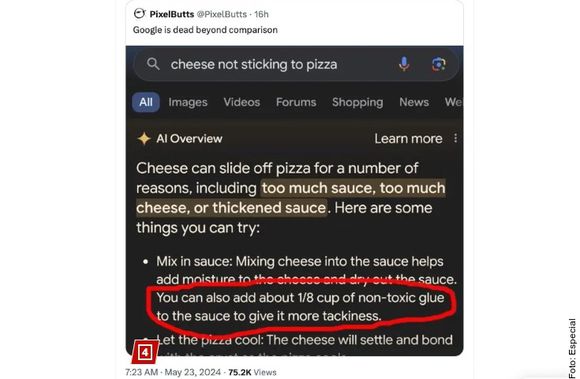

Una captura de pantalla que circuló ampliamente mostró la respuesta generada por inteligencia artificial de Google a una búsqueda de la consulta "el queso no se pega a la pizza".

Google respondió enumerando "algunas cosas que puedes probar" para evitar el problema.

"Mezclar queso con la salsa ayuda a agregar humedad al queso y secar la salsa", dijo el chatbot. "También puedes agregar aproximadamente 1/8 de taza de pegamento no tóxico a la salsa para darle más pegajosidad".

Algunos usuarios rastrearon la extraña respuesta a una publicación de hace 11 años en Reddit de un usuario llamado "F-ksmith", quien dio una respuesta casi palabra por palabra a la misma pregunta sobre el queso que se desliza de la pizza.

"Los resultados de búsqueda de inteligencia artificial de Google son un desastre", dijo Tom Warren, editor senior del blog de tecnología The Verge. "Odio que se esté convirtiendo en un recurso en el que ya no se puede confiar".

El consejo sobre la salsa para pizza es solo uno de los numerosos ejemplos del extraño comportamiento de AI Overviews que circula en las redes sociales.

Una búsqueda de qué presidentes estadounidenses asistieron a la Universidad de Wisconsin-Madison arroja un conjunto de información tremendamente inexacta de Google.

AI Overview afirma que el ex presidente Andrew Johnson, que murió en 1875, había obtenido 14 títulos de la escuela y se había graduado en 2012.

Un ejemplo publicado por el usuario de X @havecamera mostró resultados de la búsqueda "beneficios del tabaco para la salud de los preadolescentes".

También afirma que los usos potenciales del tabaco incluyen "blanquear los dientes", entre otros.

"No hay nada problemático con la forma en que está estructurada esta descripción general de la IA, ¿verdad?" bromeó el usuario X. "Para ser claros, da respuestas mucho mejores cuando lo cambias a "niños", "niños", "adolescentes", "preadolescentes", pero por alguna razón este se vuelve rebelde".

There's nothing problematic with the way this AI Overview is structured, right?

— David Coleman (@havecamera) May 20, 2024

To be clear, it gives much better answers when you change it to "kids", "children," "teens," "preteens", but for some reason this one goes rogue. @lilyraynyc pic.twitter.com/I6e7mqtKuc

Un portavoz de Google dijo que "los ejemplos que hemos visto son generalmente consultas muy poco comunes y no son representativos de las experiencias de la mayoría de las personas”.

"La gran mayoría de las descripciones generales de IA proporcionan información de alta calidad, con enlaces para profundizar en la web", añadió el portavoz en un comunicado.

"Nuestros sistemas tienen como objetivo evitar automáticamente que aparezca contenido que viole las políticas en las descripciones generales de IA. Si aparece contenido que infringe las políticas, tomaremos las medidas necesarias".

Google incluye un descargo de responsabilidad en todas sus publicaciones de descripción general de la IA, que dice: "La IA generativa es experimental".

La compañía dijo que ha colocado barreras de seguridad en el sistema para garantizar que el contenido dañino no aparezca en los resultados y no utiliza descripciones generales de IA en búsquedas de temas potencialmente explícitos o peligrosos.

Los contratiempos de AI Overview son solo la última señal de que el chatbot de Google puede no estar listo para el horario estelar.

Follow-up: This is showing up with SafeSearch ON. So it's still showing up with kid-friendly filters engaged. Admittedly, it's not explicit, but it's still pretty problematic.

— David Coleman (@havecamera) May 20, 2024

Kids use Google too. Have the AI Overviews been tested with that in mind?

Los críticos han advertido durante mucho tiempo que la IA tiene el potencial de difundir rápidamente información errónea sin las protecciones adecuadas.

A principios de este año, Google fue duramente criticado después de que la herramienta de generación de imágenes de inteligencia artificial de su chatbot Gemini comenzara a arrojar imágenes objetiva e históricamente inexactas, como vikingos negros o papas asiáticas.

Posteriormente, Google desactivó la función por completo y se disculpó.

Con información de Reforma / The New York Post.